LecPac-Consulting vous accompagne dans votre démarche pour migrer vos applications Saas sur Kubernetes.

Kubernetes est une plateforme open-source qui permet de gérer et d’orchestrer les conteneurs d’applications dans le cloud.

La migration d’une application SAAS vers Kubernetes peut offrir de nombreux avantages, tels que la scalabilité, la disponibilité et la facilité de gestion. Cependant, la migration vers Kubernetes peut être une tâche compliquée si vous n’avez pas conçu ou repensé votre application basée avec les conteneurs.

Vous devez donc bien comprendre les concepts de conteneurisation et d’orchestration de Kubernetes avant de vous lancer dans la migration de votre application.

Chez Lecpac Consulting, nous accompagnons les startups depuis des années à se lancer dans Kubernetes. C’est pourquoi nous souhaitons vous partager notre feuille de route pour bien démarrer sur Kubernetes pour la première fois.

Dans cet article, nous allons donc vous guider pas à pas à travers le processus de migration d’une application SAAS vers Kubernetes. Nous allons examiner les défis et les avantages de la migration, ainsi que les étapes clés pour réussir la migration de votre application. Nous allons également vous fournir des conseils pratiques pour tirer le meilleur parti de la migration vers Kubernetes et éviter les pièges courants.

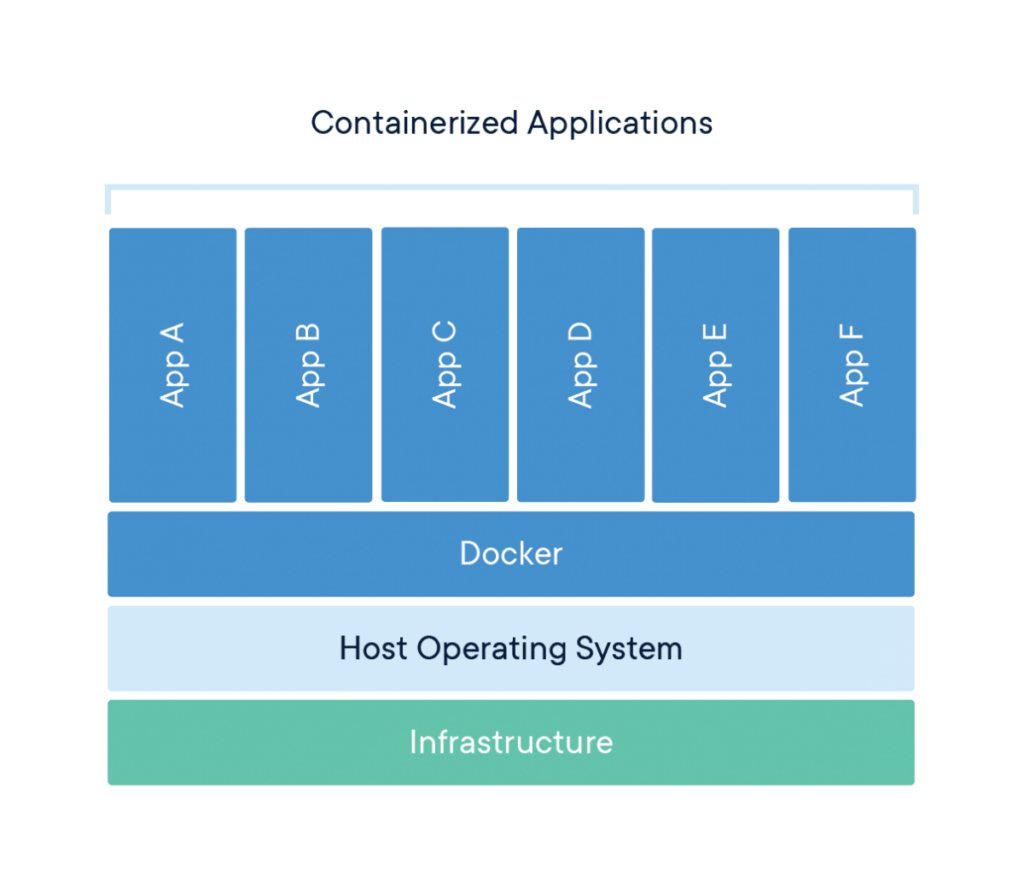

C’est quoi un conteneur d’application ?

En tant que développeur, vous savez à quel point il peut être difficile de déployer une application sur différentes machines, ou même sur différents environnements. Les différences de configuration et de dépendances peuvent être un vrai casse tête, des erreurs de déploiement et des problèmes de compatibilité.

C’est là que les conteneurs entrent en jeu. Les conteneurs sont des enveloppes virtuelles qui contiennent tout ce dont une application a besoin pour fonctionner de manière autonome, de manière cohérente et répétable.

Plutôt que de devoir configurer l’environnement de chaque machine individuellement, les conteneurs encapsulent l’application et ses dépendances dans une unité portable, qui peut être déployée sur n’importe quelle machine prenant en charge le système d’exploitation hôte.

En d’autres termes, les conteneurs vous permettent de créer des environnements de développement et de production cohérents et isolés, qui sont préconfigurés pour fonctionner correctement dès leur déploiement. Vous n’avez plus à vous soucier des différences de configuration ou de dépendances entre les machines.

Mais comment cela fonctionne-t-il exactement ? Eh bien, un conteneur est essentiellement une section partitionnée du système d’exploitation qui peut fonctionner comme une machine indépendante. Les conteneurs partagent le système d’exploitation hôte, mais sont isolés les uns des autres pour éviter les conflits et les interactions non désirées.

En résumé, les conteneurs offrent une solution pratique et portable pour la création d’environnements de développement et de production cohérents et isolés. Ils vous permettent de réduire considérablement le temps et les efforts nécessaires pour déployer et gérer vos applications.

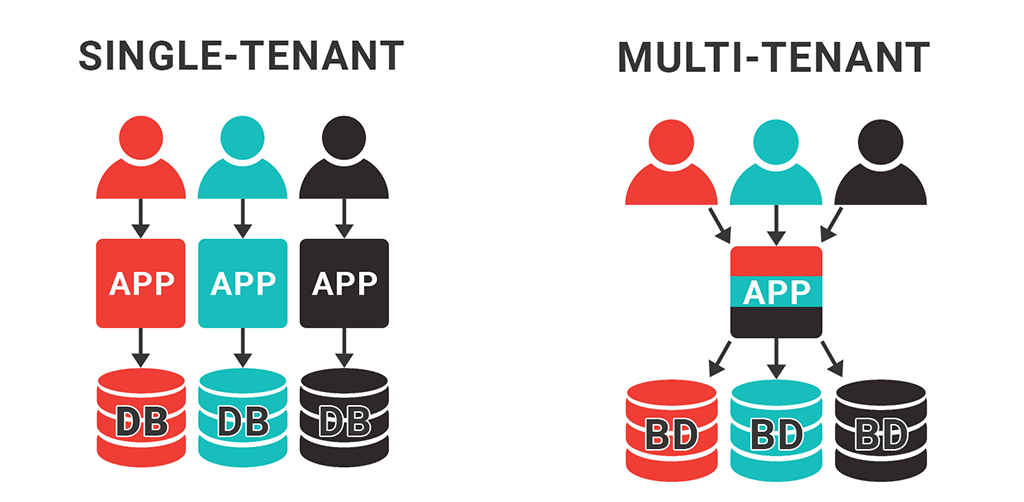

Adopter une architecture multi-tenant ?

Avant de passer à Kubernetes, vous devez examiner de près la manière dont vous fournissez actuellement votre application à l’utilisateur final. Les applications web traditionnelles utilisent une architecture multi-tenant. Cela signifie que tous vos utilisateurs partageront un seul tenant de base de données et un seul tenant d’une application.

Les avantages d’une architecture multi-tenant

Il est possible de faire fonctionner cette architecture dans Kubernetes – cependant, je vous invite à envisager la mise en œuvre d’une architecture multi-tenant pour exploiter pleinement la puissance de Kubernetes et des applications conteneurisées.

Voici quelques avantages majeurs de l’adoption d’une architecture multi-tenant:

Stabilité

Au lieu d’un point de défaillance unique (l’instance unique de l’application), chaque client peut exister dans sa propre instance. Si une instance tombe en panne, les autres ne seront pas affectées.

Évolutivité

Avec une architecture multi-instance, l’évolution est une simple question d’ajout de ressources. Cependant, avec une architecture multi-tenant, vous pouvez arriver à un point où vous devez mettre en place une architecture d’application en cluster dont le déploiement est généralement loin d’être trivial.

Sécurité

Lorsque vous utilisez une seule base de données, toutes vos données vivent ensemble. Cela devient un problème majeur en cas de violation de la sécurité, car les données de tous les clients peuvent devenir vulnérables lorsqu’un seul compte est compromis. Avec une architecture multi-tenant, seules les données d’un seul client peuvent être en danger.

Audit technique de votre architecture technique

Lorsque vous décidez de migrer une application sur Kubernetes, il est essentiel de disposer d’une compréhension technique claire de son architecture applicative.

Une documentation précise décrivant les aspects techniques pour répondre aux questions clés suivantes :

- Quelles sont les dépendances de l’application ? Il est crucial de comprendre les dépendances réseau de l’application et les services avec lesquels elle doit communiquer. Toutes les interactions entrantes et sortantes doivent être répertoriées dans une matrice pour une planification adéquate de la migration.

- Utilisez-vous des sessions persistantes ? Les sessions persistantes sont un processus dans lequel un équilibreur de charge crée une affinité entre un client et un serveur réseau spécifique pour la durée d’une session. Si votre application utilise des sessions persistantes, il est important de gérer ces sessions lors de la migration. Cela garantira une expérience utilisateur optimale.

- Votre application est-elle stateful ou stateless ? Les applications stateless ne dépendent pas d’un volume persistant, tandis que les applications stateful impliquent généralement une base de données et traitent les demandes en fonction des informations fournies. La migration d’une application stateful est souvent plus complexe que celle d’une application stateless.

Outre ces questions primordiales, il est également essentiel de comprendre la configuration de l’application, telles que les variables d’environnement, et la manière de la lancer.

LecPac Consulting peut vous aider à répondre à ces questions critiques en réalisant un audit technique approfondi de l’existant.

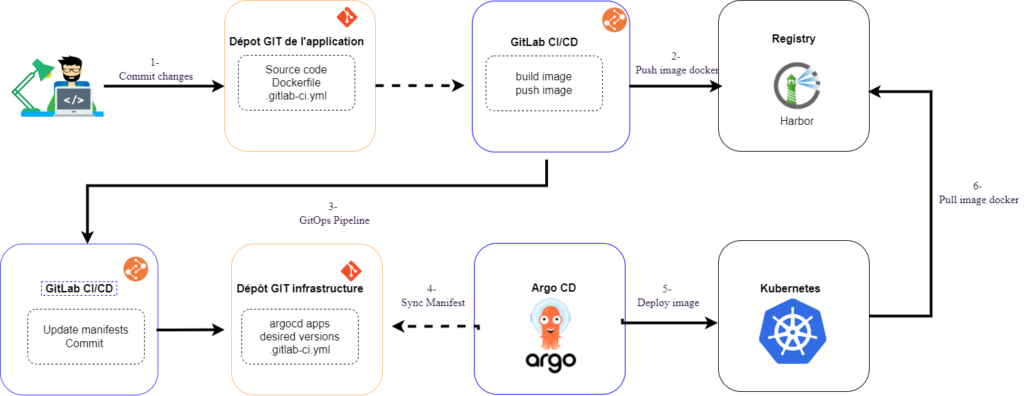

Déployer son infrastructure Kubernetes avec la méthodologie gitOps

GitOps est une approche de gestion de l’infrastructure et des applications qui utilise Git comme source de vérité. Cela signifie que toutes les modifications apportées à l’infrastructure ou à l’application doivent être effectuées via des fichiers Git, ce qui permet une traçabilité complète et une gestion efficace des versions.

Choisissez votre fournisseur Git

Dans cette approche, GitHub et GitLab sont les deux options les plus populaires pour l’hébergement de votre code source. Mais quelle est la principale différence entre GitHub et GitLab ?

- GitHub est souvent le choix privilégié pour les dépôts de sources ouverts

- GitLab est plus adapté pour les dépôts de sources privés. Particulièrement intéressant pour ceux qui souhaitent héberger leur propre serveur Git et leurs dépôts dans leur propre cluster.

Le choix de votre fournisseur Git dépendra également des personnes qui ont besoin d’y accéder. Dans GitOps, toutes les modifications apportées à l’infrastructure ou à l’application doivent être effectuées via Git. Cela nécessite que toutes les parties impliquées dans le développement et la gestion sont à l’aise avec l’utilisation de Git.

En choisissant votre fournisseur Git adapté à vos besoins et en appliquant les principes de la méthodologie GitOps, vous otiendrez :

- une gestion efficace de votre infrastructure et de vos applications

- une traçabilité complète

- une collaboration transparente entre les différentes parties impliquées dans le processus de développement.

Infrastructure en tant que code

L’infrastructure en tant que code (IaC) est la pierre angulaire de l’infrastructure cloud. Cette approche permet de décrire les ressources cloud nécessaires dans un code déclaratif simple. En optant pour l’IaC, vous êtes en mesure de définir clairement votre infrastructure, de la versionner dans Git et de la reproduire facilement en cas de besoin, pour garantir une bonne posture de reprise après sinistre.

Chaque fournisseur de cloud public possède sa propre implémentation IaC propriétaire, telle que AWS CloudFormation. Toutefois, il est préférable d’opter pour des outils IaC plus flexibles. Par exemple, l’utilisation de Terraform qui permet de ne pas être lié à un fournisseur de cloud spécifique.

Terraform est actuellement considéré comme la norme industrielle pour l’IaC. Il prend en charge un grand nombre de technologies. Pour une utilisation optimale, Terraform doit être considéré comme un plan de contrôle géré et automatisé avec un outil comme Atlantis. Ainsi, Terraform devient entièrement contrôlable et intégré aux flux de demandes de pull de vos ingénieurs dans leur fournisseur Git.

Gestion des secrets : Pourquoi vous devez en faire une priorité dès le départ

En apparence, la gestion des secrets semble être quelque chose de facile à comprendre et un problème simple à résoudre. Votre application a besoin d’un mot de passe pour se connecter à une base de données, et tant que vous pouvez stocker ce secret dans un endroit sûr, c’est suffisant, non ? Malheureusement, ce n’est pas aussi simple que cela en a l’air. Les secrets sont partout et doivent être gérés de manière efficace. C’est nécessaire pour garantir la sécurité et la protection de votre application.

Caque secret a son propre cycle de vie et ses propres exigences d’accès. Que ce soit des secrets d’application aux certificats ou aux clés SSH. Sans une gestion appropriée des secrets, ceux-ci se dispersent facilement à travers les différents systèmes. Par exemple au travers du système de secrets de votre fournisseur de cloud, votre système serverless, vos outils CI et des localhosts de vos ingénieurs. Cela rend alors les fuites de crédence faciles et la rotation difficile.

C’est pourquoi il est crucial de faire de la gestion des secrets une priorité dès le départ de votre projet. En établissant une politique saine de rotation des secrets, votre organisation peut minimiser les risques et les conséquences de toute violation de sécurité.

Stocker et gérer les secrets avec l’outil open source SOPS

Heureusement, il existe des outils de gestion des secrets efficaces tels que SOPS. Ceux-ci permettent de stocker et de gérer les secrets de manière sécurisée. Contrairement à certains outils de gestion des secrets propriétaires, SOPS est open source. Par conséquent, cela signifie que vous pouvez l’utiliser sans être lié à un fournisseur de cloud spécifique.

SOPS utilise une approche de chiffrement de bout en bout pour stocker les secrets. Vos données sont donc chiffrées dès leur création et le restent jusqu’à leur utilisation. Cela garantit que même si une personne non autorisée accède aux fichiers contenant les secrets, ils seront toujours illisibles.

En outre, SOPS prend en charge plusieurs formats de fichiers, tels que JSON, YAML et TOML. Son intégration avec les systèmes existants est alors facilitée. Il est également facile à utiliser grâce à une interface CLI simple et intuitive.

En résumé, la gestion des secrets est un aspect essentiel de la sécurité de votre organisation. En faisant de la gestion des secrets une priorité dès le départ, vous pouvez minimiser les risques de violation de sécurité et garantir la protection de vos données. Des outils tels que SOPS peuvent vous aider à stocker et à gérer vos secrets de manière sécurisée et efficace. De plus, ils garantissent que vos données sont protégées de bout en bout.

Stocker vos conteneurs dans un registre privé

Pour des raisons de sécurité, il est recommandé d’utiliser un registre privé pour stocker les conteneurs de votre base de code. En effet, cela vous permet de mieux contrôler l’accès aux images et d’éviter les risques de fuites d’informations sensibles.

De plus, il est important de prendre en compte la sécurité de vos conteneurs en activant des scans de vulnérabilités sur votre registre. Cela vous permet de détecter rapidement les failles de sécurité dans vos images. Ainsi, vous êtes réactif face aux mesures nécessaires pour les corriger avant qu’elles ne soient exploitées.

Parmi les outils disponibles pour héberger votre propre registre privé, vous pouvez opter pour Harbor, Artifactory, ou Nexus, qui offrent tous des fonctionnalités avancées pour la gestion des images de conteneurs.

En somme, bien que le choix de votre registry dépende de plusieurs facteurs, il est essentiel de prioriser la sécurité en optant pour un registry privé et en activant des scans de vulnérabilités pour protéger votre base de code et les données de votre entreprise.

DevOps : Elaboration d’un pipeline d’intégration continue

Le déploiement continu est une pratique essentielle dans le développement et la gestion d’applications Kubernetes. Elle permet de livrer rapidement des applications de qualité à grande échelle.

Pour ceux qui ne sont pas familiers avec le concept, le déploiement continu est le processus de mise en production de nouveaux changements dans l’application de manière continue et automatisée, après avoir effectué les tests nécessaires. Cela permet aux développeurs de livrer des mises à jour rapidement et en toute sécurité.

Il existe plusieurs outils de déploiement continu pour Kubernetes, mais deux des plus populaires sont Flux2 et ArgoCD.

Flux2 : un outil open source de surveillance des changements

Flux2 est un outil open source qui utilise GitOps pour gérer les déploiements continus de Kubernetes. L’outil Flux2 surveille les changements apportés au référentiel Git et les applique automatiquement à Kubernetes. Cela signifie que chaque modification de code est suivie et déployée automatiquement, permettant ainsi de minimiser le temps d’arrêt.

ArgoCD : outil open source avec tableau de bord

ArgoCD est un autre outil open source qui fournit un tableau de bord pour gérer les déploiements continus dans Kubernetes. Il utilise également GitOps pour synchroniser l’état de l’application avec le code source et permet de suivre les changements apportés. ArgoCD prend en charge les mises à jour en continu et les opérations Git intégrées.

Ces deux outils offrent une approche moderne de la gestion des déploiements continus pour Kubernetes. En utilisant GitOps, ils fournissent une transparence et une traçabilité totales de l’état de l’application, ce qui est essentiel pour la gestion des opérations de production. De plus, ces outils sont faciles à configurer et à utiliser, et ont une communauté active de contributeurs.

En fin de compte, le choix de l’outil de déploiement continu pour Kubernetes dépendra des besoins de votre organisation. Cependant, il est important de choisir un outil qui offre une visibilité complète de l’état de l’application, qui facilite la gestion des déploiements continus et qui peut s’intégrer facilement avec les autres outils de la pile Kubernetes.

Sécurisation de l’infrastructure Kubernetes

La préparation d’un environnement de préproduction pour une application est une étape essentielle dans le processus de migration. Elle permet de tester les changements et de les valider avant de passer en production. Cependant, la préparation de cet environnement doit être faite avec soin pour assurer un niveau de sécurité équivalent à la production.

Nous prenons soin de préparer les environnements Kubernetes de nos clients en suivant une pratique appelée “hardening”. Celle-ci vise à renforcer la sécurité du système en limitant les points d’entrée potentiels et en réduisant les risques d’attaques.

Pour y parvenir, nous avons suivi des étapes clés pour garantir que l’environnement soit bien sécurisé. Tout d’abord, nous avons configuré la sécurité du réseau en utilisant des options telles que :

- la segmentation du réseau

- l’isolation des pods

- la restriction de l’accès aux ports non autorisés.

Nous nous sommes également appuyés sur les recommandations de la National Security Agency (NSA) pour le “hardening” de Kubernetes, afin de garantir que notre environnement soit renforcé pour résister aux attaques potentielles.

Il convient de noter que notre infrastructure a déjà été auditée et que les mesures mises en place ont prouvé leur efficacité. Nous sommes donc confiants quant à la sécurité de notre environnement de préproduction. Celle-ci nous offre un cadre fiable et robuste pour tester les applications avant leur déploiement en production.

Test de performance et de charge

Avant de migrer une application vers un nouvel environnement, il est crucial de prendre en compte le dimensionnement. Vous devez vous assurer que l’application est capable de répondre aux exigences de production et éviter les temps d’arrêt. Pour ce faire, il existe deux approches recommandées.

La première consiste à dimensionner l’application de la même manière qu’elle l’était sur les machines virtuelles. La seconde approche, que nous recommandons vivement, consiste à dimensionner l’application en fonction des tests de charge effectués dans le nouvel environnement. En effet, cette approche permet de simuler un trafic plus important que la production. Cela permet de savoir exactement combien d’utilisateurs peuvent être pris en charge par l’application.

Bien entendu, si vous n’avez pas le temps de charger les tests de charge, cela ne doit pas bloquer la migration. Toutefois, il est fortement recommandé de prendre des précautions supplémentaires avec l’approche alternative pour garantir que l’application peut gérer le trafic de production.

Test de plan de reprise d’activité ( PRA )

Pour votre plan de reprise d’activité, nous préconisons une approche simple, reproductible et adaptable en utilisant la méthodologie GitOps. Celle-ci vous permettra de gérer et versionner votre infrastructure. Un plan simple permet une remise en état rapide de votre application. Contrairement à un plan reproductible qui doit être testé régulièrement pour éviter les surprises en cas de problème. Il est également important de garder votre plan adaptable afin de prendre en compte les évolutions de votre environnement.

Boostez la performance et la sécurité de votre SaaS en migrant vers Kubernetes

En faisant appel à notre expertise, vous bénéficierez d’un accompagnement personnalisé tout au long du processus de migration vers Kubernetes. Nous proposons un service de migration géré pour vous aider à économiser du temps et des efforts. Vous pourrez ainsi profiter d’une sécurité accrue, de performances améliorées, d’une disponibilité élevée des applications et d’une réduction de la complexité de la gestion des machines virtuelles. Nous adaptons nos options à vos besoins, que vous souhaitiez effectuer la migration en interne ou via notre service géré.

Nous travaillons en collaboration avec vous pour itérer la conception de votre application et l’aider à se transformer d’un système monolithique en microservices, pour un déploiement Agile sur notre infrastructure Kubernetes. N’attendez plus pour faire appel à nos services et simplifier votre migration vers Kubernetes.

Contactez-nous dès aujourd’hui pour en savoir plus !